Четвертый модуль All In One Seo Pack – Robots.txt. Простенький, информативный модуль проверяющий синтаксис robots.txt.

Robots.txt – некий сборник правил для роботов, запрещающий индексировать какие-либо страницы или папки вашего сайта для безопасности либо для избавления от дублей контента.

Создание файла robots.txt обязательно!

О том, как правильно создать robots.txt, я описал в этой статейке. Так же вы найдете там еще массу полезной информации на эту тему.

Ну а в этой статье, мы будем проверять его синтаксис, с модулем от уже известного нам плагина — All In One Seo.

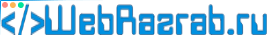

Начинается модуль с раздела “Создать Robots.txt”

Данный раздел является очень примитивным конструктором Robots.txt. Примитивным потому что с этим конструктором вы потратите уйму времени, легче просто открыть файл и сделать все руками. Это не сложно, уж поверьте мне.

Однако я все-таки напишу, что к чему.

Допустим, вы по какой-то странной причине решили воспользоваться этим конструктором.

Вам надо будет заполнить несколько не сложных полей.

Первое: вам надо выбрать тип правила

Block – почему в настройках написано “блок” не понятно. В общим команда Disallow (Block) запрещает индексацию какого-либо католога либо страницу.

Команда Allow – наоборот разрешает индексацию. Ну, просто так указывать ее не надо, поисковики и так будут индексировать все, что вы не закроете. А нужна она для того если скажем у вас есть папка /files, в папке files есть другие папки: photos, music, text и т.д. Вам нужно, что бы папка photos индексировалась, а остальные нет. Прописывать все папки нудно, для этого нам и нужен Allow.

Allow: /files/photos Disallow: /files

На данном примере можно увидеть, как работает Allow. Команда Disallow: /files закрывает папку и все содержимое в ней от индексации, а Allow: /files/photos делает исключение для папки photos и файлов в ней и разрешает индексировать ее.

User Agent – для какого поисковика мы задаем правило.

* — для всех.

Googlebot – Google.com.

Yandex – Yandex.ru.

Mail.Ru – mail.ru.

Путь к каталогу – указываем каталог, для которого создается, привило.

Например:

/files/photo

Или

/test.html

Жмем на кнопочку «добавить правило».

И внизу ведем, что появилась такая запись:

User-agent: * Disallow: test.html

Это значит, что вы добавили правило в ваш robots.txt. Осталось только сохранить изменения нажав на “Сохранить Robots.txt”.

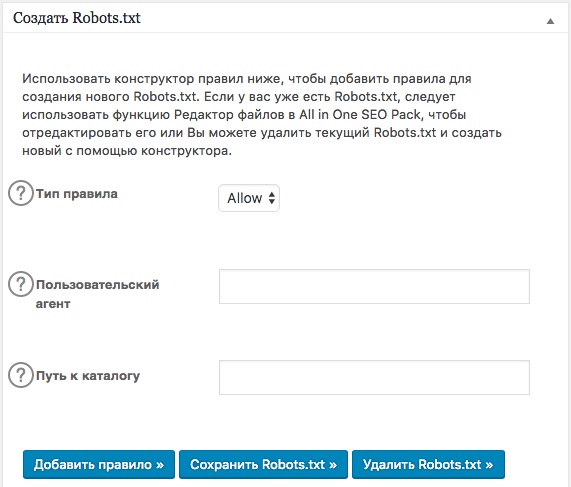

Второй раздел “Оптимизировать Robots.txt”.

Жмем на кнопочку оптимизировать, страница обновляется и вылезает список, поделенный на две колонки. В первой колонке отображаются код вашего robots, а во второй оптимизированный. Если вам нужны изменения, нажимаем на кнопку “Обновить Robotx.txt“ если не нужны “Игнорировать изменения”.

Будьте внимательны, сканер принимает за ошибку директиву HOST, которая нужна для яндекса.

На этом все, успехов. Вам понравилась эта статья?